- SEO

Agencia SEO

Aproveche el primer canal de adquisición de tráfico confiando su posicionamiento orgánico a una agencia digital con experiencia en SEO.

- SEM

Agencia SEM

Amplíe su negocio rápidamente con la búsqueda de pago (SEM).

- Social Ads

Social Ads

Optimice sus campañas de publicidad en redes sociales para mejorar su rendimiento.TikTok AdsViraliza tus anuncios en TikTok

- Agencia

La Agencia

Keyweo nació del deseo de crear una agencia que cumpla con los principios de transparencia, confianza, experiencia y rendimiento.

- Blog

- Contacto

Análisis de logs SEO

Inicio > Agencia SEO > Glosario SEO > Analisis de logs SEO

Definición

El análisis de logs nos permite ver la información que los bots han obtenido de nuestras páginas al rastrearlas. Como pueden ser, las carpetas que más solicitudes han recibido, los códigos de respuesta del servidor, qué tipo de bot ha entrado, el tiempo que ha tardado en rastrear la página, los tipos de archivo que han rastreado, etc. Para poder entender por qué es tan importante, debes saber que, cuando los robots navegan por la página web, dejan un rastro de información, así podemos ver su comportamiento. El análisis de este rastro, permite saber cómo los bots interactúan con nuestra web. Al extraer esta información de nuestras páginas web debemos actuar basándonos en los resultados que obtenemos. En este artículo encontrarás toda la información necesaria para hacer un análisis de logs.

¿Qué es un Log?

Los logs son registros (ficheros) que guardan información sobre toda la actividad de lo que ocurre en una web. En otras palabras, cada vez que un bot accede a una web, se hace una petición al servidor, y si hay un error en el sistema o se ha accedido correctamente, se guarda en un log.

En los servidores web, los logs registran detalles como: la dirección IP, qué parte de la web intentó visitar, la fecha y la hora de la petición, el tipo de petición, la URL rastreada, el código de respuesta y el robot que ha rastreado. Esta información es útil, por ejemplo, para saber cómo los robots de Google exploran una página web y los problemas eventuales que encuentran.

Los logs ayudan a entender qué está pasando en el sistema, para el SEO es muy importante detectar cuando estas peticiones no van bien. Cada sistema puede tener su propio formato de logs, y aunque existen logs predeterminados, muchos prefieren usar los suyos propios.

Aquí explicaremos, paso a paso, la mejor manera de analizar los logs.

¿Cómo analizar Logs para SEO?

Los logs no se guardan por siempre, depende de la compañía de hosting, así que si quieres tener una buena base de datos los puedes descargar. Hay diferentes formas de analizar logs de tu web, existen muchas herramientas que puedes usar para analizar esta información, pero la más actual y fiable la tiene el servidor donde está alojada tu web.

- Debes acceder a tu panel de control del servidor con tu alojamiento.

- Haz clic en la pestaña de “Sitios web y dominios”

- Por ahi, deberias encontrar la opción de “Registros” o “Logs”

- Ya tienes tu listado de logs.

Cuando tengas tu lista de logs, hay que saber cuáles son los más importantes que debes tener en cuenta a la hora de intentar optimizarlos.

Buenas herramientas para analizar Logs

Existen ciertas herramientas que hacen mucho más fácil la presentación e interpretación del análisis de logs. Las recomendadas en este artículo, son de las más precisas que existen, siendo la primera de ellas, una herramienta muy potente que proviene del mismo Google.

Google Search Console

Esta opción es algo más directa, nos dirigimos a Google Search Console. Es la herramienta de Google que proporciona los datos sobre el estado de tu web.

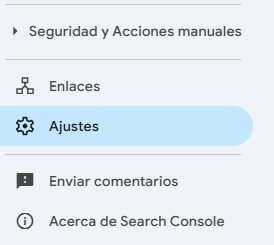

En la parte de la izquierda, hay una columna de navegación, ahí hay que clicar donde se encuentra el apartado de Ajustes.

En la parte de “Rastreo” encontraremos los informes sobre robots.txt y estadísticas de rastreo. En este caso, abrimos el informe de Estadísticas de rastreo.

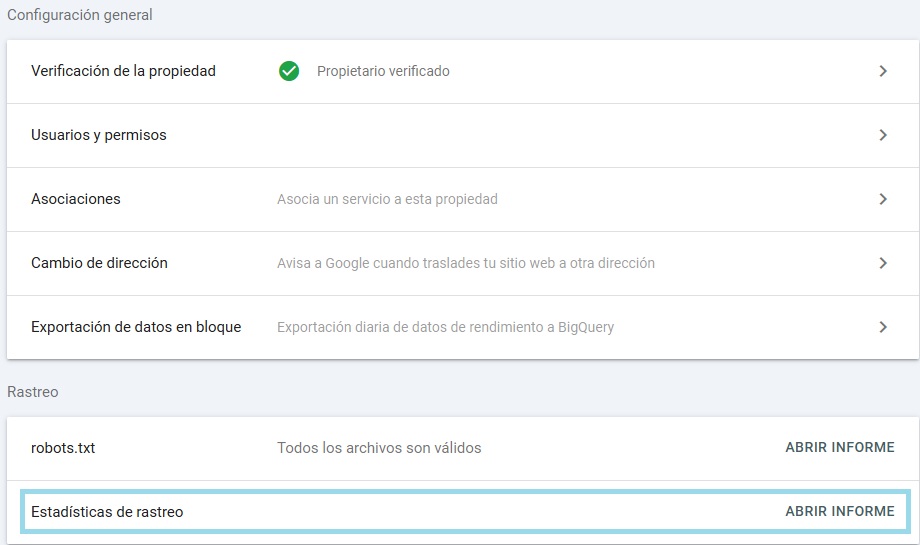

Encontraremos las métricas de:

- Total de solicitudes de rastreo.

- Tamaño total de la descarga (Tamaño que pesa cada URL).

- Tiempo medio de respuesta (Cuanto mayor sea el tiempo peor)

El apartado de HOST tenemos los dominios que gestionamos. Al clicar en uno de ellos obtendremos el Gráfico General con las métricas anteriores y las submétricas:

- Tiempo de respuesta por código devuelto: El objetivo es obtener casi todo el tanto por ciento en el código de respuesta 200.

- Tipos de archivo de la web: Indica el tipo de archivo que más predomina en tu web. Como css, lenguaje html, javascript, imagen u otros.

- Por finalidad: Cómo ha detectado las páginas, si es por actualización o detección. Es bueno para la web si el robot ha encontrado las páginas por actualización, porque significa que hay contenido nuevo.

- Tipo de robot: Robot de móvil, robot de imágenes, robot de ordenador, robot de ads, etc. Son las estadísticas de qué robot de Google ha rastreado cierta información.

Screaming Frog Log Analyzer

Cuando tengamos los datos descargados desde el servidor, otra opción muy buena para analizar logs es cargar los archivos con Screaming Frog Log Analyzer, es un programa distinto al de Screaming Frog, te dejamos una guía detallada si quieres saber cómo usarlo. Para ello, antes de nada, debemos descargar el programa. Si tienes la versión de pago, puedes obtener más datos durante el tiempo anterior.

- Haz clic en Proyectos – Nuevo Proyecto – Dar un nombre.

- Cargar el archivo de logs descargado del servidor.

- En la parte superior de las pestañas, encontraremos filtros sobre qué tipo de Bot queremos que nos muestre la información y las fechas exactas. Estos filtros los puedes ir alternando para analizar diferentes elementos.

Analizar las URL’s que Google tiene más en cuenta de nuestra web

Deberían ser páginas que nos generen negocio o que sean de las más importantes de nuestra web. Esto es importante para analizar si tiene sentido lo que está pasando.

- En el apartado Filtro, debajo de las pestañas, filtraremos por HTML para obtener datos de Google Bot.

- En la pestaña de URL podemos ver todas las páginas que más solicitudes han recibido.

- Nos fijaremos en la columna de Núm. de eventos, porque las URL’s que tengan más solicitudes significa que Google le tiene más cariño. Suele ser debido al enlazado interno y enlazado externo, tiene mucho que ver.

Analizar y mejorar el crawleo de Google

- En el apartado Filtro, debajo de las pestañas, filtraremos por “TODAS” para obtener las URL’s que son priorizadas en el crawleo.

- En la pestaña de URL, de nuevo, podemos ver todas las páginas que más solicitudes han recibido.

- Nos preguntaremos si tiene sentido que Google priorice estas páginas. Si no es el caso, porque se trata de una página que a nivel de contenido e información no aporta mucho al robot. Una opción sería que lo bloqueásemos en robots.txt para decir al bot que no priorice este tipo de páginas y, por ende, mejore el crawl budget.

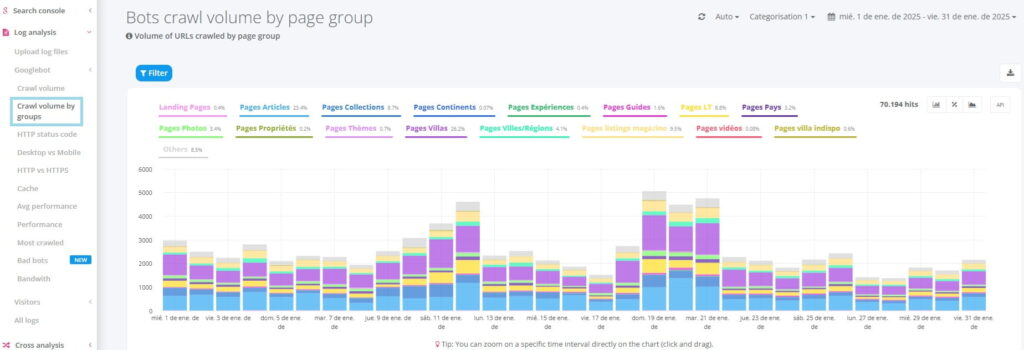

Seolyzer

Seolyzer es una herramienta potente para analizar logs de tu web de forma sencilla y desde el punto de vista puramente SEO. Esta herramienta es de pago, tiene muchas funciones interesantes, aunque en este artículo nos centraremos en las funciones básicas de SEO. Este es el paso a paso básico para obtener la información de los robots:

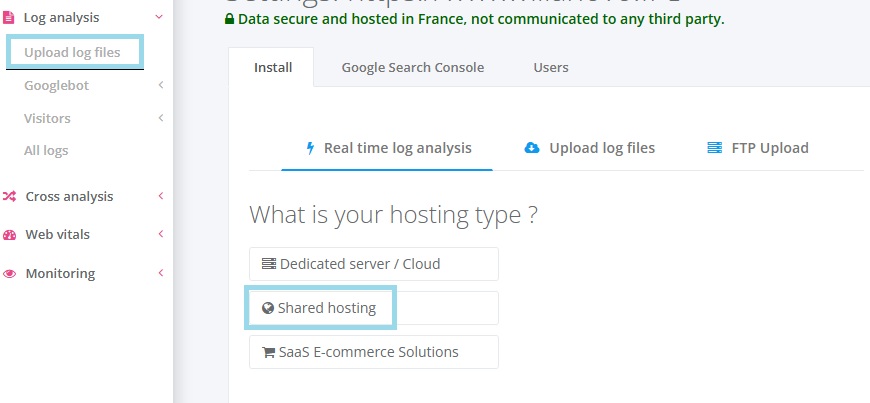

- Una vez conectado a la herramienta, podrás configurarla para recuperar datos. Según el tipo de servidor que uses debes clicar en “Servidor dedicado” u “Hosting compartido”. En este caso usamos el compartido y clicaremos en “Shared hosting”.

- Para que pueda rastrear toda la información, proporciona un código PHP para subirlo a la raíz de nuestra web. Y ya tendremos todo preparado para que la herramienta nos proporcione los datos de logs de nuestro sitio web.

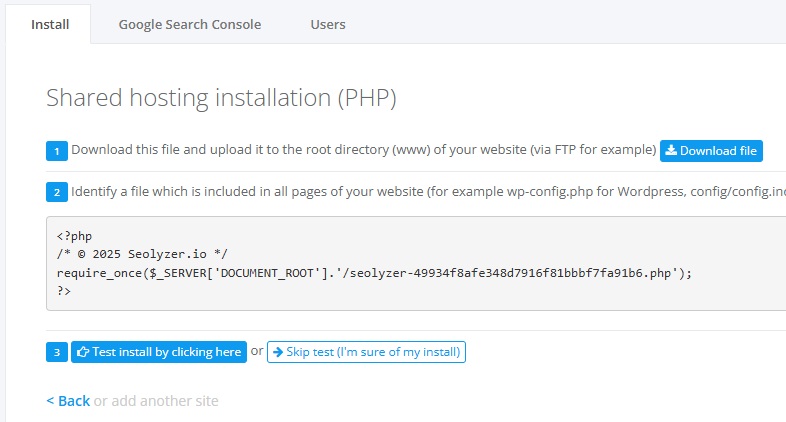

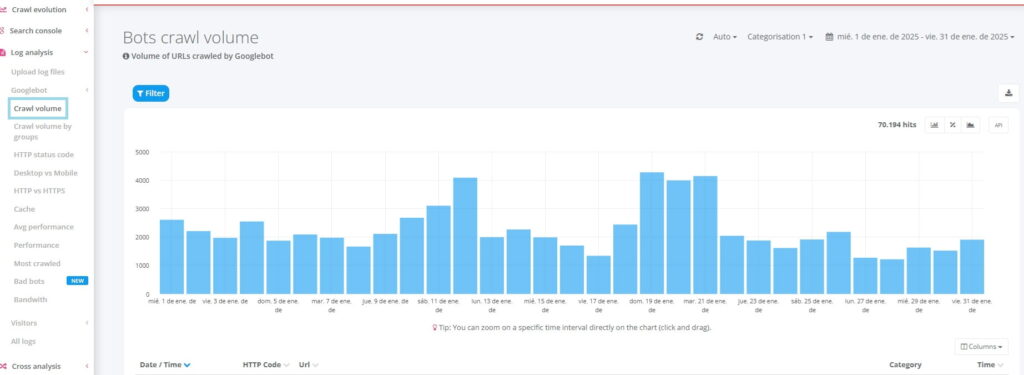

Usaremos la columna lateral para navegar y observar qué ha encontrado Seolyzer en nuestro dominio. Sobre todo, nos mantendremos en la parte de análisis de log – Googlebot. Recuerda que en la parte superior a la derecha, puedes cambiar la fecha para que cambie la información.

- Volumen de crawleo: Nos enseña que ha hecho Googlebot en nuestra web. En otras palabras, es un resumen de la información recopilada por el bot. Con el filtraje puedes añadir columnas y tener una visión más global.

- Volumen de crawleo por grupos: Podemos crear grupos de páginas en que estemos interesados en recibir información. Por ejemplo, agrupar páginas por clúster o por tipo de página (producto, categoría, blog, etc.).

- Código de respuesta: Nos muestra el código de respuesta que ha obtenido el bot basándose en las solicitudes de entrada que le ha hecho al servidor. Más abajo del artículo se explica el significado de cada código.

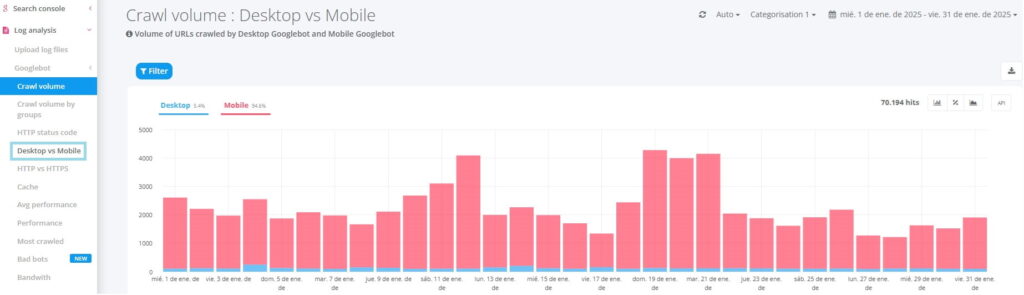

- Móvil vs ordenador: Qué bot visita más la web, la versión para móviles o la versión de ordenador. Recuerda que en los últimos años Google le ha dado mucha importancia al robot de móvil.

- Páginas más rastreadas: Una de las secciones más importantes. Cuáles son las páginas que más solicitudes de entrada han recibido. La columna de “hits” son las veces que ha sido rastreada por el bot. Esta información indica que el bot está más interesado en unas páginas que en otras. Si hay páginas que crees que no son importantes para tu web y están obteniendo muchos rastreos, deberías tomar decisiones.

Información más valiosa de los Logs para el SEO

Solicitudes con error 50X

Estos errores son de tipo servidor, significa que no tienen nada que ver en cómo está hecha nuestra página web. Es el servidor que en ese preciso momento no ha funcionado correctamente y devuelve este código, por eso, la importancia de contratar un buen hosting. También se puede deber a que el servidor se ha caído durante un intervalo de tiempo y eso conlleva consecuencias negativas con la indexación de nuestra web. En todo caso, podemos contactar con el desarrollador web para sacarnos de dudas.

Solicitudes con error 40X

Es necesario identificar los errores que devuelven un código 40X, lo que significa que la URL que ha navegado el bot no existe. Puede deberse a que una página se ha caído, la hemos eliminado o se ha accedido a una URL no existente por error. Para que el bot no se encuentre con este tipo de errores, estas páginas deben ser redireccionadas a otra página que tenga relación.

En caso de que una URL con este código obtenga enlaces, ya sean interno o externos se deben corregir apuntando a las páginas funcionales que más relación tengan con los enlaces que recibe.

Solicitudes con redirecciones 301

Tener páginas con redirecciones 301 es normal, no te preocupes. Estas páginas con redirecciones ayudan a que no haya errores en la navegación, aunque se debe tener un buen control de qué páginas tienen este código. Es importante remarcar que las páginas con 301 no obtengan enlaces internos o externos porque su función es hacer de puente entre 2 páginas. Los enlaces que apunten a estas URL’s deben apuntar a la URL final.

Número de solicitudes por carpeta

Esta información nos aporta cuáles son las carpetas de nuestra arquitectura que más solicitudes recibe. En otras palabras, nos indica las páginas más importantes o de más relevancia para los bots.

Debemos tener en cuenta que cuantas más URL’s cuelguen de una carpeta normalmente más solicitudes recibe, por lo que es importante entender el ratio de peticiones para entender la relevancia.

El tiempo y la frecuencia de rastreo de un BOT

Con el análisis de logs para el SEO podemos observar que páginas están siendo poco visitadas o rastreadas. La estrategia es desarrollar un método navegacional para que los bots puedan acceder de forma más sencilla a estas páginas. Con un enlazado interno en la arquitectura interna favorece sustancialmente el rastreo de estas páginas.

En caso de que una URL no tenga este tipo de enlaces, no hay una forma fácil de crawlear la página, puede que no se indexe y no aparecerá como resultado.

El peor de los casos es la existencia de páginas huérfanas, son páginas que no reciben enlaces y de las cuales no se puede accederdentro de la estructura de un sitio web. Cuantas menos páginas de este tipo tengamos mejor para nuestra web.

Estos 5 elementos son los que más impacto SEO tienen en caso de que las estadísticas mejoren. No es una tarea sencilla, pero la importancia de ellas es vital para tu sitio web.

Cuándo es necesario hacer un análisis de logs

No siempre es necesario de dedicar tiempo para dedicar al análisis de logs, pero en algún momento, sí que se vuelve imprescindible. Además, es una forma de sanar nuestra web en caso de que tenga problemas como los que hemos visto anteriormente.

Has hecho cambios en la arquitectura seo de tu web

Cuando estamos trabajando en mejorar el posicionamiento orgánico de nuestra web, a menudo es necesario hacer cambios en la arquitectura, es decir, en cómo están organizadas las páginas y cómo se conectan entre sí. Esto puede incluir cambios en reorganizar el menú, actualizar los enlaces internos o incluso cambiar algunas URL’s. Después de realizar estos cambios es muy importante asegurarnos de que los bots de los motores de búsqueda, están rastreando correctamente las nuevas URL’s que se han modificado.

En caso de no poder acceder a estas URL’s es posible que no se puedan indexar y afectaría negativamente al tráfico y posicionamiento.

Tienes una web muy grande

Es importante realizar análisis de registros SEO de forma recurrente, especialmente cuando el sitio web en el que estamos trabajando tiene muchas URL, varias decenas de miles, cientos de miles o incluso millones. Esto suele ocurrir en sitios web de noticias y comercio electrónico con muchos productos.

Tienes problemas con la indexación de páginas

Si estás enfrentando problemas de indexación para que tus páginas aparezcan en los resultados de búsqueda, es una buena idea analizar los registros de acceso (logs). Esto permitirá saber a qué URL’s están accediendo los bots de los motores de búsqueda. Así, podremos comprobar si están visitando las URL’s que queremos que sean indexadas. Es importante que antes verifiques que la página tiene la etiqueta robots con el valor “index”, que no esté bloqueada por robots y también que la página devuelve un código 200 (indicando que la página está disponible)

Los bots más comunes que rastrean nuestra web

El buscador más importante del mundo como es Google, dispone de múltiples de ellos, cada uno tiene un trabajo en específico que le ayudará a entender mucho mejor del contenido hay en nuestra web y de qué trata. Estos son los más importantes:

- Googlebot: Es el encargado de encontrar y crawlear nuestras páginas webs para luego poder indexarlas.

- Google adsbot: Se encarga de la parte de publicidad. Se encarga de las campañas creadas en Google Ads y se encarga de visitar las landing pages creadas específicamente para esas campañas.

- Google Images: Rastrea cualquier información sobre las imágenes que hay en la página. Cualquier optimización en las imágenes será de gran importancia para él.

- Google News: La sección de noticias es su especialidad, cualquier nueva entrada e información nueva la rastreará.

- Google videos: La incorporación de vídeos puede ser relevante para ciertos contenidos, por eso Google tiene un BOT específico para esta práctica.

- Google adsense: La práctica de publicidad es una forma de poder monetizar tus páginas. Este es el encargado de rastrear toda la publicidad mostrada en las webs y controlarla.

- Google mobile: Uno de los más importantes en los últimos años, debido a que los usuarios cada vez realizan más búsquedas en móvil que en ordenador. Se encarga de rastrear la web con el formato móvil para indexarla.

Existen otros que también rastrean nuestra web de vez en cuando, que hacen solicitudes al servidor para poder acceder. No siempre recibiremos solicitudes de bots con buenas intenciones que solo quieran rastrear nuestra web.

Hay casos en los que las solicitudes se realizan con demasiada frecuencia, lo que puede ralentizar y evitar que otros rastreen el sitio sin problemas. En estos casos, podemos intentar controlarlos mediante el archivo robots.txt o, más radicalmente, el archivo .htaccess.

Conclusión

Ahora ya sabes de qué trata un análisis de logs y la importancia que tiene dentro del mundo del SEO. Esta práctica poderosa te ayudará a optimizar el rastreo de los motores de búsqueda, identificar y corregir problemas técnicos y mejorar la visibilidad de un sitio web en los resultados de búsqueda.

Preguntas frecuentes

Analizar los datos almacenados en el servidor de un sitio web, en forma de archivos de registro de la interacción entre un servidor y un bot que ha rastreado la web.

En este artículo explicamos de qué trata el análisis de archivos de registro y cómo puedes analizarlos fácilmente.

Al descargar los logs de tu servidor e intentar entenderlos no es una tarea fácil. Por eso en el artículo recomendamos una serie de herramientas con las que podrás hacer tu análisis de logs sin complicaciones.

- Recuerda recopilar bien los datos.

- Analízalos con una herramienta recomendada para encontrar patrones.

- Monitorea y configura la herramienta.

Existen numerosas herramientas que puedes usar para analizar los registros del servidor y el bot que ha rastreado tu web.

Recomendamos 3 herramientas que creemos que son las mejores, para entender la información:

- Google Search Console

- Screaming Frog Log Analyzer

- Seolyzer

Las definiciones más populares

cabecera

páginas alias

página amp google

página huérfana

página de acceso

página satélite

página de zombie

paginación en seo

pie de página

puerta de enlace de la página

sitemap

Aumenta tu visibilidad

No dudes en ponerte en contacto con nosotros para obtener un presupuesto gratuito y personalizado.

Notez ce page