- SEO

SEO Bureau

Profiteer van de eerste schakel in het werven van verkeer door uw SEO toe te vertrouwen aan een digitaal bureau met ervaring in SEO.

- SEA

SEA Bureau

Laat uw bedrijf snel groeien met betaald zoeken (SEA).

- Social Ads

Social media ads

Optimaliseer uw advertentiecampagnes op sociale media om uw prestaties te verbeteren.

- Bureau

Het online bureau

Keyweo is ontstaan uit de wens om een bureau te creëren dat voldoet aan de principes van transparantie, vertrouwen, ervaring en prestatie.

- Blog

- Contact

SEO Log Analyse

Home > SEO bureau > SEO begrippen > SEO Loganalyse

Definitie

Loganalyse is het onderzoeken van serverlogbestanden om te zien hoe zoekmachinebots met je website omgaan. Het biedt inzichten in botverzoeken, responsecodes, crawlpatronen en technische problemen. Deze problemen kunnen van invloed zijn op hoe goed je site wordt geïndexeerd en hoe goed deze presteert in zoekresultaten.

Door logs te analyseren, kun je zien welke pagina’s bots prioriteit geven. Je leert ook hoe vaak verschillende secties worden gecrawld en wat efficiënte crawling kan blokkeren. Dit proces helpt je om je crawlbudget te optimaliseren. Het zorgt ervoor dat zoekmachines je meest waardevolle content kunnen vinden, crawlen en indexeren. Uiteindelijk verbetert dit je SEO-prestaties en rankings.

Wat is een log?

Een logbestand is een record dat wordt gegenereerd door webservers en elke aanvraag van je website documenteert. Deze bestanden registreren gedetailleerde informatie over elke interactie, of deze nu afkomstig is van:

- Zoekmachinebots

- Reguliere gebruikers

- Andere geautomatiseerde systemen die je site bezoeken.

Serverlogs bevatten meestal:

- IP-adres aanvragen

- Tijdstempel van het onderzoek

- Gebruikte HTTP-methode

- Aangevraagde URL

- Geretourneerde responscode

- Overgedragen bytes

- User agent-string

Logbestanden geven een volledig overzicht van wie en wat je website bezoekt, en wanneer.

Hoe analyseer je logs voor SEO?

Het analyseren van servicelogbestanden voor SEO omvat een gestructureerd proces van:

- Gegevensverzameling

- Filteren

- Interpretatie

Deze stappen onthullen hoe zoekmachinebots met je website omgaan. Je kunt beginnen met:

- Downloaden van ruwe logbestanden van je server en deze chronologisch organiseren voor consistentie.

- Gebruik user agent-strings om botverkeer te filteren. Dit isoleert SEO-relevante data van algemene gebruikersactiviteit.

- Groepeer de URL’s per site sectie of content type. Begrijp welke gebieden de meeste aandacht van bots krijgen.

- Onderzoek responscodes om technische problemen te identificeren die crawling en indexering hinderen.

- Analyseer crawlfrequentie om te zorgen dat zoekmachines je belangrijkste pagina’s prioriteren. Monitor veranderingen die op problemen kunnen wijzigen.

- Zoek naar trends in botgedrag, zoals trage responstijden of hoge foutpercentages. Deze signaleren optimalisatiemogelijkheid.

Door deze data te interpreteren, kun je het crawlbudget optimaliseren en technische problemen oplossen. Loganalyse is essentieel voor het behouden van crawl efficiëntie en het maximaliseren van SEO-prestaties.

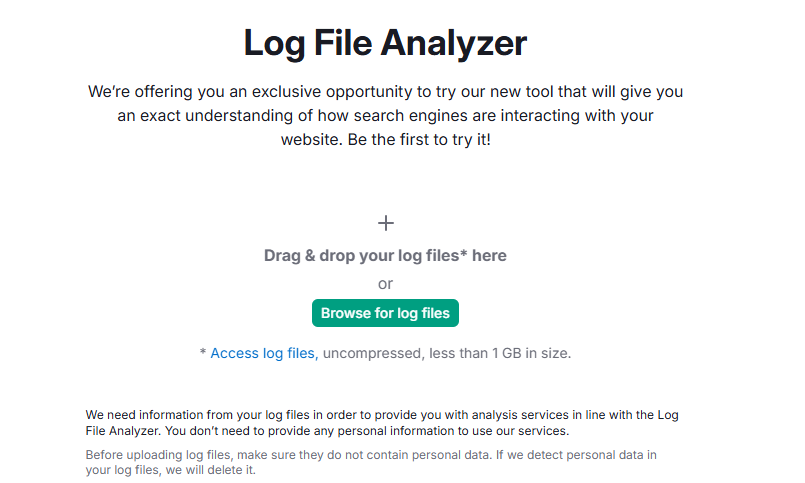

Krachtige tools voor logbestandanalyse

Loganalysetools zetten ruwe data om in bruikbare SEO-inzichten. Ze filteren, verwerken en visualiseren informatie. Deze platforms bieden verschillende functies, afhankelijk van je doelen en technische ervaring.

Professionele SEO-tools hebben geavanceerde filters, automatische foutdetectie en gedetailleerde rapporten. Deze functies maken loganalyse gemakkelijker. Kies je tool op basis van de grootte van je site, technische behoeften en budget.

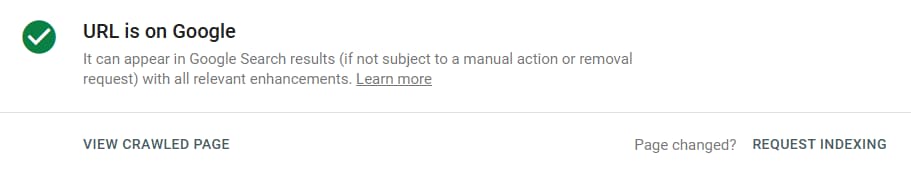

Google Search Console

Google Search Console werkt goed met logbestand-analyse. Het laat zien hoe Google je site crawlt en indexeert. Deze inzichten helpen je het botgedrag beter te begrijpen.

- Crawlstatistieken tonen hoe vaak Googlebot je site bezoekt. Je ziet totale verzoeken, gemiddelde responstijden en downloadgroottes. Dit geeft een basis om je loggegevens mee te vergelijken.

- Indexdekking laat zien welke pagina’s Google heeft gecrawld en geïndexeerd, en welke problemen hadden. Vergelijk deze data met je loganalyse om issues te ontdekken.

- URL-inspectietool toont details over individuele pagina’s, inclusief crawlgeschiedenis, indexeringsstatus en technische problemen. Gebruik dit om problemen uit je logs te onderzoeken.

- Core Web Vitals koppelen paginasnelheid aan crawlgedrag. Langzame pagina’s worden mogelijk minder vaak gecrawled.

Screaming Frog Log Analyser

Screaming Frog Log File Analyser is ontworpen voor SEO-professionals. Het kan grote logbestanden verwerken en zet ze om in duidelijke, bruikbare rapporten.

- Botfiltering helpt je te focussen op specifieke zoekmachines. Je kunt ook alle botactiviteit samen bekijken.

- URL-niveau analyse toont welke pagina’s de meeste bezoeken van bots krijgen. Zo vind je content die meer aandacht nodig heeft of verbeterd kan worden.

- Responsecode-rapporten benadrukken technische problemen. Groepeer ze om te bepalen wat eerst opgelost moet worden.

- Crawlbudget-tools helpen pagina’s te identificeren die botresources verspillen. Dit zijn pagina’s zonder SEO-waarde die toch gecrawld worden. Exporteer data om in andere tools of rapporten te gebruiken.

Vergelijkingsfuncties laten je crawlveranderingen in de tijd volgen. Zo meet je effecten van SEO-wijzigingen of ontdek je vroeg nieuwe issues.

Andere nuttige tools

Seolyzer

Seolyzer is een cloudgebaseerdetool met realtime tracking. Het werkt met populaire CMS-platforms en automatiseert veel SEO-taken. Het helpt verspild crawlbudget op te sporen, botgedrag te monitoren en meldingen bij problemen te sturen. Het dashboard is gemakkelijk te lezen en toont belangrijke statistieken duidelijk.

Semrush log file analyzer

Deze tool koppelt loggegevens aan de rest van Semrush’s SEO-suite. Je kunt crawlpatronen koppelen aan zoekwoordranglijsten, backlinks en informatie over concurrenten. Het geeft je loggegevens meer context.

OnCrawl

OnCrawl is ideaal voor grote, complexe websites. Biedt geavanceerde analyse en indeling van gegevens en datavisualisatie. Handelt miljoenen pagina’s en geeft diepgaande technische analyse.

Botify

Botify combineert loganalyse met crawldata. Geeft volledig inzicht in hoe bots je site benaderen, nuttig voor technische SEO-verbeteren.

Waardevolle SEO-inzichten uit logbestand-analyse

Detecteren van 5xx servicefouten

Serverfouten zoals 500, 502 en 503 blokkeren bots van toegang tot content. Deze fouten wijzen vaak op ernstige technische problemen.

- 500 (internal server error): Vaak veroorzaakt door software- of databaseproblemen.

- 502 (bad gateway): Meestal gerelateerd aan CDN’s of proxyproblemen.

- 503 (service unavailable): Komt voor bij overbelasting of onderhoud. Frequente fouten kunnen capaciteitsproblemen signaleren.

Controleer deze fouten regelmatig en werk samen met ontwikkelaars of hostingprovider om de oorzaak op te lossen.

Signaleren van 4xx clientfouten

Client-side problemen zoals 404 en 403 blokkeren bottoegang en verspillen crawlbudget.

- 404 (not found): Gebroken links of verouderde URL’s.

- 403 (forbidden): Bottoegang geblokkeerd door permissies.

- 410 (gone): Het beste voor intentioneel verwijderde pagina’s

Los interne links op, werk sitemaps bij en zorg dat cruciale pagina’s crawlbaar zijn.

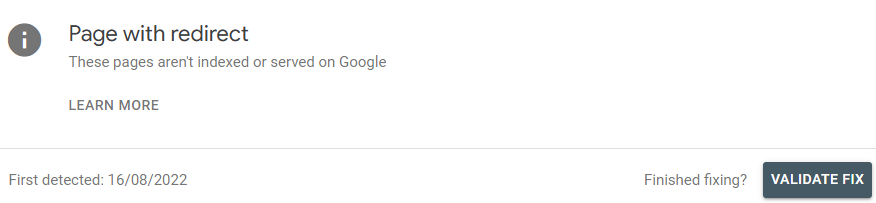

Redirect monitoren

Redirect logs tonen hoe goed je site URL-wijzigingen afhandelt:

- Vermijd redirect ketens en redirect loops om crawlbudget te behouden.

- Gebruik 301 (permanent) boven 302 (tijdelijk) voor langdurige veranderingen.

- Monitor redirect snelheid, trage redirects kunnen crawl-efficiëntie schaden.

Analyse van crawl per site sectie

Het controleren van crawlverdeling per map helpt zichtbaarheid van content te verbeteren.

- Secties met hoge crawlfrequentie hebben vaak betere interne linking of contentwaarde.

- Laag gecrawlde gebieden hebben mogelijk betere navigatie interne linking nodig.

- E-commerce sites moeten crawling van productcategorieën en filters analyseren.

- Zorg dat blogarchieven en updates gelijkwaardige aandacht blijven krijgen.

Tracking van bot-crawltiming

Weten wanneer bots crawlen helpt serverbelasting en timing van updates te optimaliseren.

- Zoek naar piekuren van crawling en pas content-updates hierop aan.

- Track veranderingen in frequentie, dalingen kunnen wijzen op technische of contentproblemen.

- Vergelijk desktop- vs mobiele botactiviteit voor mobile-first readiness.

Deze 5 factoren hebben de grootste impact op SEO als je statistieken verbeteren. Het is niet eenvoudig, maar de relevantie is cruciaal voor je website!

Wanneer moet je loganalyse uitvoeren?

Weten wanneer logbestanden geanalyseerd moeten worden, helpt je SEO-resources verstandig in te zetten. Zo kun je technische problemen oplossen voordat ze ranking beïnvloeden. Regelmatig monitoren is nuttig, maar bepaalde scenario’s maken loganalyse vooral belangrijk:

Na SEO-architectuurwijzigingen

URL-wijzigingen, interne linking of vernieuwde navigatie kunnen beïnvloeden hoe zoekmachines crawlen. Loganalyse controleert of bots zich goed aanpassen. Het toont of bots belangrijke pagina’s vinden en crawlbudget niet verspillen aan oude of dubbele content. Het controleert ook of redirect na een migratie goed werken.

Voor hele grote websites

Grote sites zoals enterprise-platforms of nieuwswebsites hebben regelmatige loganalyse nodig.Het helps bij het beheren van crawlefficiëntie en zorgt dat belangrijke content voldoende aandacht krijgt. Het onthult ook crawltraps zoals faceted navigation.

Bij indexeringsproblemen

Als pagina’s niet verschijnen in zoekresultaten, helpt loganalyse uit te vinden waarom. Het laat zien of bots die pagina’s crawlen tegen issues zoals 404-fouten of tegen geblokkeerde bronnen aanlopen. Ook helpt het vertragingen in indexering of slechte afhandeling van dubbele content te ontdekken.

Deze problemen kunnen je zichtbaarheid in zoekmachines schaden.

Veel voorkomende crawlers en bots die je site bezoeken

Het begrijpen van zoekmachinebots en hun gedrag helpt bij het optimaliseren voor meerdere zoekmachines en het effectief beheren van crawlbudget. Elke bot heeft eigen prioriteiten en crawlpatronen.

- Googlebot domineert websiteverkeer en is de belangrijkste crawler voor SEO-succes. Google heeft meerdere gespecialiseerde bots voor verschillende contenttupes en doelen.

- Googlebot desktop crawlt pagina’s zoals ze voor desktopgebruikers verschijnen.

- Googlebot Mobile richt zich op mobiele versies voor mobile-first indexing. Optimaliseer beide versies.

- Google Images bot crawlt en analyseert afbeeldingen. Belangrijk voor visuele zoekprestaties.

- Bingbot vertegenwoordigt Microsoft’s zoekmachine en heeft andere crawlpatronen dan Google.

- Yandex Bot richt zich op Russische content en markten. Baidu Spider richt zich op Chinese gebruikers.

Best practices voor loganalyse

Regelmatig logbestanden controleren

Wekelijkste monitoring detecteert snel fouten of dalingen in botbezoeken. Maandelijkse diepgaande analyses tonen langetermijntrends. Kwartaalreviews koppelen technische inzichten aan bredere SEO-doelen. Post-update analyse controleert of wijzigingen geen crawlproblemen veroorzaken.

Integratie met andere SEO-tools en data

Combineer logdata met Search Console om afwijkingen tussen botactiviteit en indexering te ontdekken. Analytics toont hoe crawlproblemen gebruikers beïnvloeden. Ranktracking koppels rankingdaling aan crawlproblemen. Snelheidsmonitoring toont of trage pagina’s crawl beperken.

Focus op crawlbudget-optimalisatie

Identificeer sterke pagina’s en controleer botbezoeken. Loganalyse onthult verspilling op lage waarde pagina’s zoals duplicaten of admin-secties. Optimaliseer interne links naar belangrijke content. Los technische problemen op zoals trage pagina’s of serverfouten.

Gebruik inzichten om fouten op te lossen en crawl-efficiëntie te verbeteren

Log bestanden tonen terugkerende fouten en technische problemen. Los eerst problemen op die veel bezochte pagina’s raken. Verbeter snelheid en serverprestaties voor hogere crawl-efficiëntie. Optimaliseer site architectuur zodat bots content gemakkelijker vinden en indexeren.

Samenwerking tussen ontwikkelaars en SEO-teams

Loganalyse moet direct in ontwikkelworkflows terugkomen. Zet inzichten om in technische taken, prioriteer op SEO-impact. Werk samen met developers om fixes te volgen en resultaten te meten. Bevorder kennisdeling zodat teams begrijpen hoe hun werk SEO beïnvloedt. Zo ondersteunen toekomstige updates crawling en indexering.

Conclusie

Loganalyse geeft inzicht in zoekmachinegedrag en maakt datagedreven optimalisatie mogelijk.

Deze krachtige techniek laat precies zien hoe bots je website benaderen. Het helpt technische problemen, crawlbudgetverspilling en architectuurproblemen te ontdekken.

Regelmatige loganalyse handhaaft optimale crawl-efficiëntie. Het zorgt dat belangrijke content de juiste aandacht krijgt van zoekmachines en voorkomt dat technische problemen, rankings en organisch verkeer benadelen.

Vergroot uw zichtbaarheid

Twijfel niet en contacteer ons voor een gratis en gepersonaliseerde offerte op maat.

Notez ce page